# Shrnutí

Sumarizace textů je jednou z běžných prací při tvorbě přirozeného jazyka. Souhrn textu přichází v široké škále forem a aplikací. Schopnost rychle a jednoduše shrnout články a koncepty je jedním z nejzajímavějších potenciálních využití jazykových modelů. Zkusme jednoduché shrnující cvičení založené na pohotovosti.

Jazykové modely jsou zvláště schopné dokončovat klasifikaci a řadu dalších úkolů zpracování přirozeného jazyka (NLP), přestože se učí vytvářet přirozený jazyk a související úkoly.

# Odpověď na otázku

Zlepšení formátu výzvy je jednou z nejlepších strategií, jak povzbudit model, aby reagoval na konkrétní odpovědi. Jak již bylo zmíněno, výzva může integrovat instrukce, kontext, vstupní a výstupní znaky, aby bylo dosaženo lepších výsledků . I když tyto komponenty nejsou potřeba, jsou dobrou praxí, protože čím jasnější jsou pokyny, tím lepší jsou výsledky. Zde je příklad toho, jak to může vypadat po strukturovanější výzvě.

# Klasifikace

Doposud jsme postupovali podle přímých pokynů k dokončení úkolu. Jako rychlý inženýr budete muset zlepšit svou schopnost poskytovat lepší pokyny. Ale počkat, je toho víc! Zjistíte také, že pro složitější případy použití nebude stačit pouhé poskytnutí pokynů. Tehdy byste měli více přemýšlet o kontextu a různých výzvách. Vstupní data a příklady jsou dva další aspekty, které můžete dodat.

# Konverzace

Jednou z nejzajímavějších věcí, kterých můžete dosáhnout pomocí rychlého inženýrství, je vyškolit systém LLM o tom, jak se chovat, o jeho cílech a identitě. To je zvláště užitečné při vývoji konverzačních systémů, jako jsou chatboti pro péči o zákazníky .

# Generování kódu

Generování kódu je jedna aplikace, ve které LLM excelují. Copilot je skvělý příklad. S důmyslnými návrhy můžete provádět nepřeberné množství činností při generování kódu.

Jak vidíte, ani jsme nepotřebovali identifikovat jazyk. Vezmeme to trochu nahoru. Rád bych ukázal, jak efektivní mohou být LLM s trochou více práce při navrhování výzev.

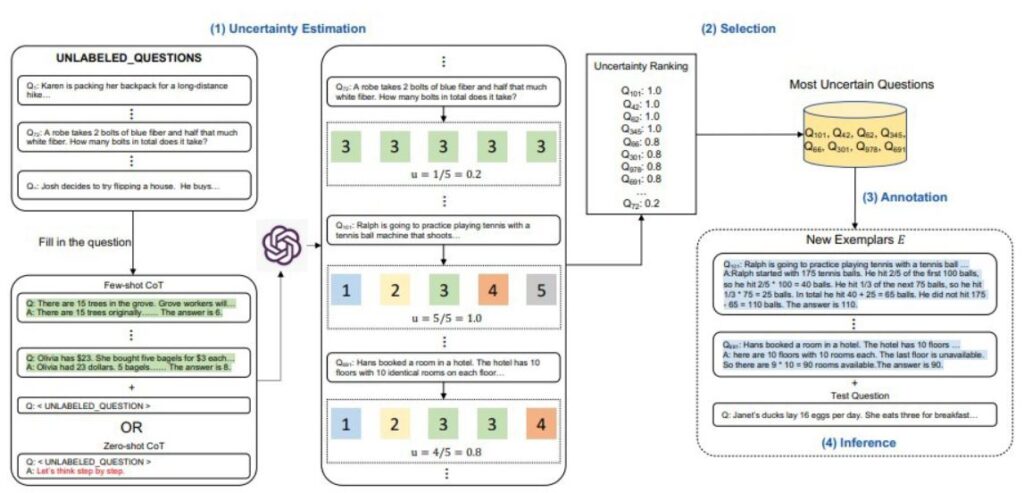

# Uvažování

Jedna z nejobtížnějších věcí pro LLM dnes může vyžadovat určitou úroveň uvažování. Vzhledem k typům komplikovaných aplikací, které mohou vycházet z LLM, je uvažování jednou z oblastí, které mě nejvíce zajímají.